近年来随着智能移动终端和互联网的快速发展,视频数据呈现指数级增长。视频目标分割拥有众多的消费落地场景,特别是最近火爆的视频会议、视频直播、短视频制作等场景中的应用极为广泛,因此如何为用户打造更智能、更优质、更沉浸的体验,实现对视频中兴趣对象的高精度自动分割,成为了非常热门的研究方向。由阿里云视频云主办的全球视频云创新大赛,在算法赛道重点攻克视频目标分割方向,就此,我们展开了解这项技术的发展、价值和关键要素。

作者|中间

业界公认的技术难点

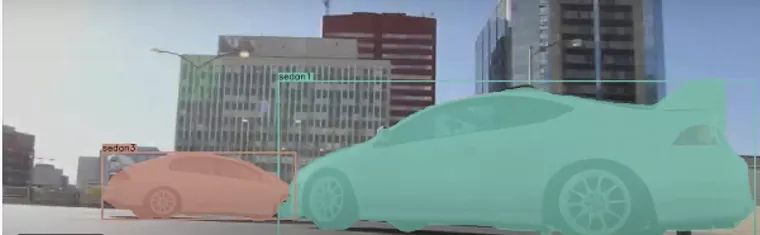

视频目标分割( Video Object Segmentation,简称为 VOS )旨在在整个输入视频序列中对目标对象实例进行高质量的分割,获取目标对象像素级的蒙版,从而把目标从背景图像中精细的分割出来。相比于目标跟踪、检测等限位框级任务(用矩形框将目标框选出来),VOS 具有像素级精度,更利于准确定位目标以及勾勒目标边缘细节。

视频对象分割是计算机视觉领域的基本任务之一,也是业界公认的技术重点和难点,在视频理解和编辑,高清视频压缩,人机交互以及自动驾驶等领域具有广泛的应用价值和落地需求。同时,视频目标的分割结果也是视频内容生产二次创作的重要素材,能够赋能内容生产者,提升内容生产效率。

视频目标分割技术在自动驾驶领域的应用 图片来源:(CVPR), 2021 。

图像分割算法有较长的研究历史,从最早的阈值化、直方图、区域生长、k - 均值聚类、分水岭方法,到更先进的主动轮廓模型、Graph-cuts 、条件随机场和马尔可夫随机场等方法。

近年来随着深度学习的快速发展,基于深度神经网络产生了一批新一代的分割模型,其性能获得了显著提高,在流行的基准测试上通常都达到了最高的准确率。在视频场景下,相比于单纯地逐帧实现图像分割,视频目标分割依托于多帧间的连续性,可以实现分割结果的高平滑、高精度。

从应用条件和场景的角度出发,视频对象分割可分为无监督(弱监督) VOS 、半监督 VOS 和交互式 VOS。

半监督 VOS 依托视频第一帧一个(多个)对象的真实分割蒙版,自动估算其余帧对象的细化蒙版。

交互式 VOS 依靠用户的简单互动,如涂鸦或点击,提供待分割目标的大致位置,进而估算、细化目标的精确蒙版。

无监督 VOS 是全自动的视频目标分割方法,最具挑战性,仅依靠视频输入(单目 RGB ),分割视频中显著目标的精细蒙版,相比于半监督和交互式,无监督 VOS 需要定义显著性目标并提供额外的显著性物体检测模块。然而 VOS 算法除了要解决图像分割面临的视角变化、光照变化、目标尺度变化、遮挡等难点之外,视频场景下复杂的背景干扰、目标物体运动模糊以及目标周围复杂的附属物等,都对 VOS 算法提出了巨大的挑战。同时,视频数据处理数据量通常是几十倍于图像数据,因此 VOS 算法的计算量和复杂度也成了限制 VOS 能否成功应用的重要衡量标准,随着视频目标分割技术热度的持续增加,越来愈多的视频算法模型衍生出来。

图片来自论文 Video Object Segmentation with Re-identification,CVPR 2017

算法模型加速创新

近年来视频目标分割算法有基于第一帧的 mask 进行传播的,也有基于检测在线学习的,STM[1] 的出现融合了上述两种思想的优点,首次将 Memory Network 引入 VOS 领域,引申为一个 space-time 的 memory network,并实现了较好的分割准确率以及较快的速度。在业界著名的 DAVIS 2020 大赛中,很多优秀的模型都是根据 STM 进行改造的,可见其具有很棒的指导意义和研究价值。下面,我们就以 DAVIS 2020 大赛的优胜方案为例,介绍几种具有代表性的算法。

阿里达摩院提出的算法 [2] 是 DAVIS-20 半监督 VOS 赛道的冠军方案,它基于 STM,以 ResNeST101 为 backbone,增加空间约束模块( Spatial Constraint Module )以确保相邻帧之间的空间一致性,消除外观混淆,消除由同一类别的相似实例引起的错误预测,并在 segmentation head 中增加了 ASPP (Atrous Spatial Pyramid Pooling) 模块来解决尺度变化( scale variability )的问题,同时使用了额外的 refinement module 来提升分割图像边缘的精细度。

CFBI[3] 提出了一种前背景整合的协作式视频目标分割算法,也是一种基于匹配的半监督分割算法,与之前的方法只考虑前景目标特征学习不同的是,CFBI 开创性的同时、同等地处理前景和背景信息,不仅提取当前帧的嵌入特征并与参考帧中的前景目标进行匹配,而且还对背景区域进行匹配以缓解背景混乱,从而得到更好的分割结果。CFBI 进一步拓展了在多尺度特征上进行匹配,在 DAVIS2020 半监督分割赛道上与达摩院的算法性能接近,获得第 2 名。

Garg 等人提出的框架 [4] 是 DAVIS-20 无监督 VOS 赛道的冠军方案,主要结合了 Proposal 和 STM,首先利用 Mask-RCNN 生成第一帧中可能的目标分割 mask ( proposal ),接着利用 STM 将第一帧的 Proposal 顺序传导到其余帧,再将 STM 预测的 mask (带 ID )与第一帧的 Proposal 建立匹配关系,最后筛选出最准确的 mask 作为最终的分割结果。阿里提出的无监督 VOS 方案 法 [5] 与 [4] 一样利用了 Proposal 和 STM 来实现整个算法,主要是利用跟踪来融合不同的 proposal,在无监督 VOS 赛道中获得亚军。目前主流的无监督 VOS 跟上述两个工作的思路基本一致。

更精、更快、更融合

目前对视频目标分割的研究主要分为两方面,一是如何利用视频帧之间的时序信息提高图像分割的精度;二是如何利用视频帧之间的相似性确定关键帧,减少计算量,提升模型的运行速度。

在提升分割精度方面一般是设计新的模块,将新模块与现有的 CNNs 结合;在减少计算量方面,利用帧序列的低层特征相关性选择关键帧,同时减少操作时间。具体来说,视频目标分割这几年的发展代表了科研领域对 sequential data 的认识有了很大的进展,无论是视频数据还是文本数据本质上都是 sequential data,在 NLP 领域通过 attention 机制对全局信息进行建模之后,这种思路在视频领域也逐渐成为了一种共识。

所以,一个很重要的方向是多领域的融合,像视频目标跟踪( VOT )、检测( VOD )、ReID 、视频理解以及更大的 meta learning 、video representation learning 、few-shot learning 、metric learning 跟视频分割都是高度相关的。

第二个是找到一种统一的解决方案,比如用一个网络解决无监督和半监督 VOS,甚至是解决视频目标跟踪( VOT )、视频目标检测( VOD )和多目标跟踪( MOT )等问题。

第三个是探索一些更加高效的训练范式,视频数据的标注非常困难且成本很高,结合半监督或者无监督的学习方法,一定会为视频目标分割带来比较大的变革。

参考文献

[1] Oh S W, Lee J Y, Xu N, et al. Video object segmentation using space-time memory networks[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2019: 9226-9235.

[2] Zhang P, Hu L, Zhang B, et al. Spatial Consistent Memory Network for Semi-supervised Video Object Segmentation[C]//CVPR Workshops. 2020, 6.

[3] Yang Z, Wei Y, Yang Y. Collaborative video object segmentation by foreground-background integration[C]//European Conference on Computer Vision. Springer, Cham, 2020: 332-348.

[4] Garg S, Goel V, Kumar S. Unsupervised Video Object Segmentation using Online Mask Selection and Space-time Memory Networks[J].

[5] Zhou T, Wang W, Yao Y, et al. Target-Aware Adaptive Tracking for Unsupervised Video Object Segmentation[C]//The DAVIS Challenge on Video Object Segmentation on CVPR Workshop. 2020.

视频云大赛正在火热报名中

扫码或点击下方链接,一起驱动下一代浪潮!

https://tianchi.aliyun.com/specials/promotion/videostreamingcloud_2021