作为一支专注于 AI 的小团队,我们和许多开发者一样,在模型训练的道路上饱受算力短缺的困扰。

昂贵的显卡、主流云平台漫长的排队、复杂的环境配置,以及因闲置而不断燃烧的经费,都曾是我们的日常。我们把大量时间浪费在了等待和运维上,而不是真正投入到算法和产品创新中。

我们受够了这种低效。为了彻底解决自己的问题,我们决定打造一个我们心中理想的 GPU 云平台。它必须足够简单、高效、且便宜。

我们如何解决共同的痛点?

我们把所有踩过的坑,都变成了「共绩算力」的核心特性:

-

告别排队,即开即用:我们投入重金储备了千卡级的 RTX 4090/5090 现货。你不再需要为资源排队等待,在浏览器里就能直接进入熟悉的 Jupyter Lab 、VS Code 或 Bash 终端,随时开始工作。

-

只为有效算力付费:我们坚信,一分钱都不该为闲置浪费。因此,我们实现了精确实在的「按秒计费」,关机即停费,开关机过程零费用。RTX 4090 每小时仅需 1.68 元,真正做到用多少、付多少。

-

三分钟上手,专注开发:我们预装了涵盖 PyTorch 、TensorFlow 、ComfyUI 、Stable Diffusion 等在内的主流镜像。你无需再为繁琐的环境配置分心,所有工具开箱即用。

-

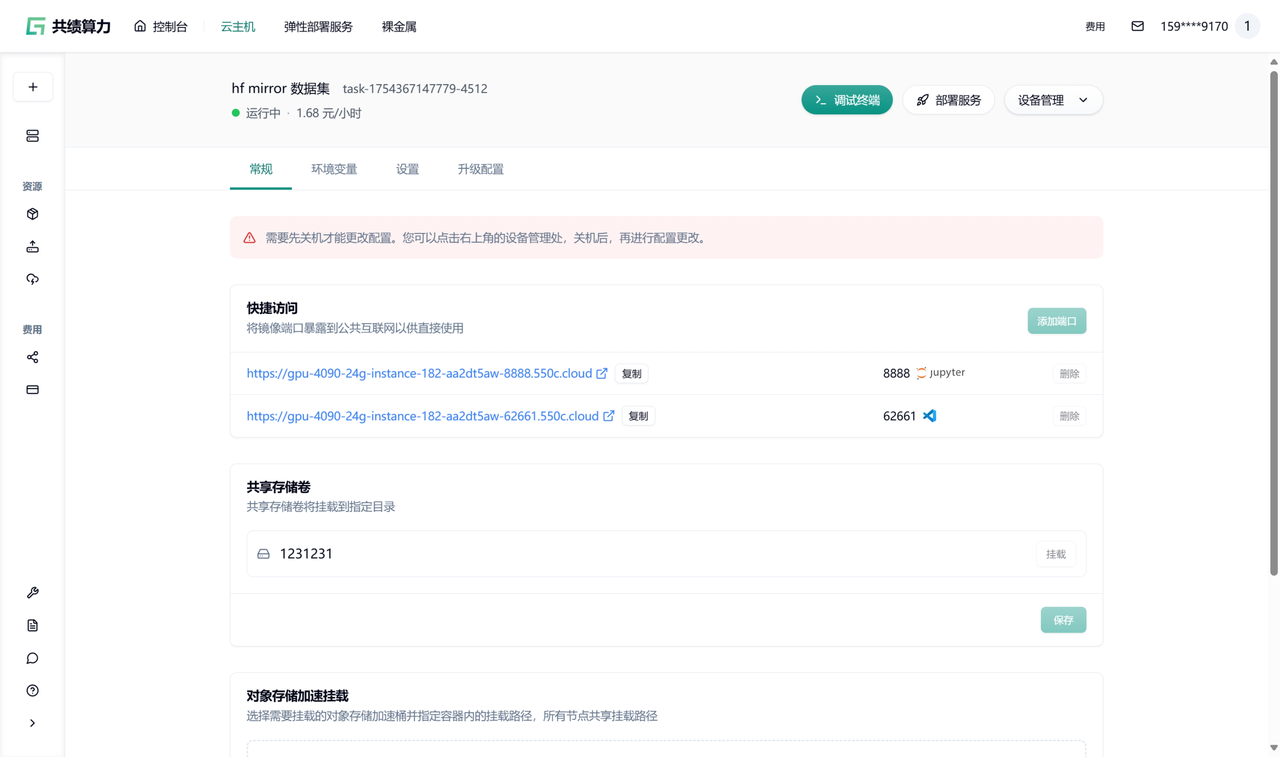

数据无忧:我们提供了共享存储卷和 S3 挂载加速功能,让你的数据集、代码和模型权重安全、高效地在不同任务间流转。

我们追求极致的性价比

我们将自己作为第一个用户,围绕开发中最耗费心神的几个环节,做了针对性的优化。我们的目标是在同等价格下,提供最稳定、流畅的体验。

| 维度 | 共绩算力 | 解决了什么问题 |

|---|---|---|

| 可用性 | RTX 4090/5090 千卡现货 | 无需排队,即刻开始。 |

| 价格 | 4090: 1.68 元/时,5090: 2.5 元/时 | 成本比主流云厂商降低 30-60%。 |

| 计费 | 按秒计费,关机实例不收费 | 资金不再为闲置浪费。 |

| 启动速度 | 3 分钟内进入开发环境 | 告别漫长等待。 |

| 环境 | 预装常用镜像,内置清华 pip 源 | 免除环境配置的烦恼。 |

| 协作 | 教师/主管一键分发镜像 | 团队协作、教学培训效率倍增。 |

在真实场景中的表现

我们也在用「共绩算力」进行着模型微调、原型开发等工作。以下是一些真实场景的成本与效率参考:

- Llama 3 微调:使用单张 RTX 4090 进行 Llama-3-8B LoRA 微调,4 小时训练成本约 6.7 元,关机后 0 成本。

- Kaggle 竞赛:赛前冲刺,临时租用 8 张 RTX 4090 使用半小时,赛后立即释放,总花费不到 80 元。

- AI 教学:教师为上百名学生分发预设好的镜像,课后统一关机,人均成本不到一杯奶茶。

- 服务部署:在 ComfyUI 中调通工作流后,可以直接打包成弹性 API 服务,无需二次部署。

快速上手

我们把上手流程设计得非常简单,三分钟就能跑起你的第一个任务:

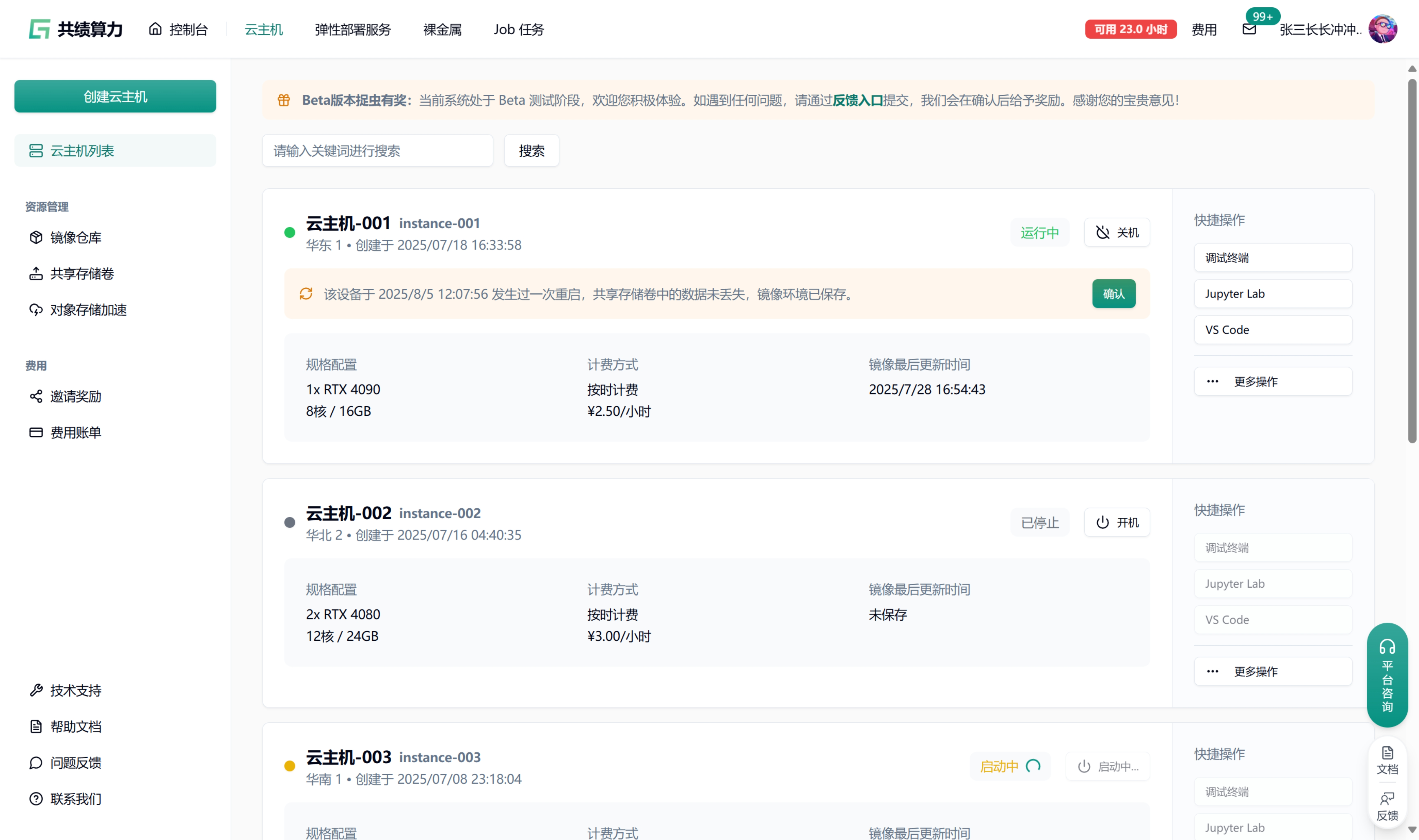

- 前往「共绩算力」控制台,进入云主机界面。

- 挑选你需要的 GPU 型号和数量。

- 为你即将创建的实例命名,并选择一个预装好的基础镜像。

- 如果需要,可以挂载一个共享存储卷用于数据持久化。

- 点击「创建实例」,完成。

现在,你可以全身心投入到 AI 开发的乐趣中了。

我们为你准备了 10 元的算力体验券,点击下方链接注册即可领取。希望「共绩算力」也能成为你手中那把趁手的“炼丹”工具。

1

panxi 2025 年 8 月 7 日

相比于 autoDL 你们的优势是什么?

|

3

maocat 2025 年 8 月 7 日

都天使轮拉几千万的投资了,找些销售对接高校呗

|

5

Dav1s 2025 年 8 月 7 日

请问有海外节点吗

|

6

nexmoe OP @crazychang 目前暂时还没有,不过这两年有出海的计划~

|

7

ssyoha 2025 年 8 月 7 日

有 A100 的 GPU 服务器吗

|

8

hahahahahahahah 2025 年 8 月 7 日

怎么还需要绑定微信才能使用

|

9

darksword21 PRO 目前用 autodl 碰到过的问题:

负载均衡升级导致访问 comfyui 频繁 nginx 502 网络不稳定,因为要从 s3 拉图片然而 autodl 同区域共享带宽,有时候一个小图要拉好几分钟 其他没什么问题了 |

11

nexmoe OP @hahahahahahahah 前段时间被莫名其妙的匿名手机号攻击了,所以引入绑定微信避免机器人攻击 😂

|

12

nexmoe OP @darksword21 刚好我们最近就在努力解决这方面的问题

|

13

huangliang1427 2025 年 8 月 7 日

最近微调模型总是找不到卡,来试试你们家

|

14

liu731 PRO 其实作为一个经常短期租赁 GPU 服务器的用户来说,痛点是下载模型慢+困难。价格倒是不太看中(公司出钱)

|

15

Solix 2025 年 8 月 7 日

replicate 才是未来

|

16

MaybeRichard 2025 年 8 月 7 日

@huangliang1427 #13 之前跑实验充多了还剩几千余额,兄弟你需要吗

|

19

woctordho 2025 年 8 月 7 日 via Android

你们有推荐的存储 10T 左右数据集的地方吗

|

20

monkeyWie 2025 年 8 月 7 日

我咋记得你们平台之前宣传的是做 C2C 算力租赁的,现在换路线了吗

|

21

mscb 2025 年 8 月 7 日

4090 本身对多 GPU 训练也不算支持的太好,其实单卡比友商便宜一点,对于训练来说也差不了几块钱,训模型优先还是会用 A100 这种。你们可以在推理上多发发力,我们公司遇到的最大的痛点是模型部署问题。像我们小公司,模型多,请求不大,又不值得单独租 GPU 机器(成本太高)。用阿里的 serverless 能解决按量付费的问题,可是冷启动又太慢(毕竟他们是通用的架构),差不多要 1 ~ 2 分钟整个模型对外的 API 才可用。国外的平台,延迟高,充钱也不方便,所以也没试过。不知道你们平台有没有办法解决这个问题。

|

24

nexmoe OP |

25

xiaowoli 2025 年 8 月 7 日

哥们 为啥你们页面这么卡啊,点个页面要等 3 ,4 秒

|

28

woctordho 2025 年 8 月 7 日

@nexmoe 我在考虑训练一个开源的音乐生成模型,类似于 Chroma

Chroma 是基本由一个人训练出来的图像生成模型,他花了大概半年,数据量是 10T 的数量级 目前我觉得算力相对比较好找,但是把 10T 的音乐数据搬来搬去比较麻烦,所以我需要先把这方面考虑清楚再开始训练 |

29

baiyi 2025 年 8 月 7 日

|

30

mscb 2025 年 8 月 7 日

@nexmoe #24 我看了下你们的文档,目前是要自己调用 API 扩缩容。而且看起来侧重于从 1 到 N 的扩容。到时候会实现从 0 到 1 的自动扩容吗?

|

31

nicoljiang PRO 这个是不是挺早的,记得之前见过。但你们控制台的响应是真的不咋快。

|

32

zhengfan2016 2025 年 8 月 7 日

|

34

nexmoe OP @zhengfan2016 是的

|

35

nexmoe OP @nicoljiang 今年就会优化了

|

36

xgq89757 2025 年 8 月 7 日

后面会有 NPU ,DCU 吗?

|

37

a56143575 2025 年 8 月 7 日

共绩科技 2023 年成立于"清华",专注于构建融合算力与电力的智能调度网络

|

38

kebamt 2025 年 8 月 7 日

校招去了解过你们,感觉不太靠谱,再看看吧,目前在用其他平台

|

39

bt7vip 2025 年 8 月 8 日 via Android

搭建成本上,推理卡是不是比计算卡要便宜,我在想如果给用户卡,让用户跑自己的模型,这个有没有市场。终端用户可以根据自己的需求跑各种不同模型,满足在一个平台上使用多个模型的需求,自建还不会遇到因为使用过多出现被降智问题,提供商按推理使用时常收费,用户只关心我用的什么卡和那个模型,你们只负责卡稳定运行。这是面对推理场景,我看网站页面感觉像是面对开发者的计算场景。

|

44

rosslu 2025 年 8 月 8 日

@crazychang 我有海外 gpu 资源,可以申请测试

|

45

Thiece 2025 年 8 月 10 日

如果是面向 AI 的话,为什么没有 Pro 6000 的节点呢?这个不比 5090 的性价比高多了

|